前回に引き続き、ChatGPTに印刷会社の新人向けのテスト問題を解いていってもらいます。ぜひとも模範解答を出してもらい、解答・解説を用意する手間を省きたい新人への教育に活用したいところ。後編では問題の難易度を上げて、ChatGPTのポテンシャルの限界に迫ります!

求ム、模範解答

想像以上の出来!?

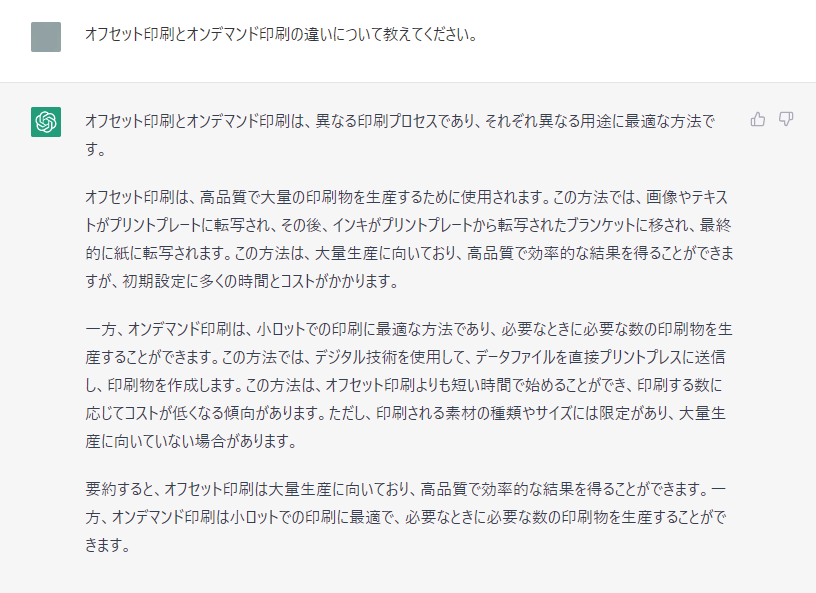

後半1つ目はこちらの問題からスタート。

「オフセット印刷とオンデマンド印刷の違いを教えてください。」

今までのように当てはまる選択肢や数字・正誤を答えるのではなく、一から文章の形で解答してもらう、いわゆる記述式の出題になります。前編の傾向から、話が具体的なしくみなどに及ぶとちょっと頼りない解答が出てしまいそうなので、あえてかなりふわっとした問題で試してみましょう!

さて、ChatGPTの回答は……

……採用! 想像以上の出来です。

それぞれのしくみを軽くふまえつつ、どんな用途に向いているのかも書けています。厳しく見ていくとやはりしくみの記述に若干あやふやなところはありますが、2つの特徴をきちんと対比できていますね。要約までついているので妙に説得力があります。

まさしく模範解答。入社早々の新人がもしこれだけの答えを出してきたのなら、細かい点には目をつぶって満点としてもよいかもしれません。ChatGPTおそるべし……

重箱の隅をつつくのであれば「なぜオフセット印刷は大ロットに向いているのか」「なぜオンデマンド印刷は小ロットに適しているのか」の2つの説明が見当たらないことでしょうか。前者については松本清張の『鬼畜』の記事でも取り上げましたが、版の摩耗を抑えることで版交換の頻度が減り、一気に大量部数の印刷が行えるため。後者は版を作らないことで製版工程をまるごと省略でき、工数とコストの削減が可能になるためです。こちらは画像生成AIの記事で登場しましたね。

AIなのに○○が苦手!?

次が最後の問題になります。

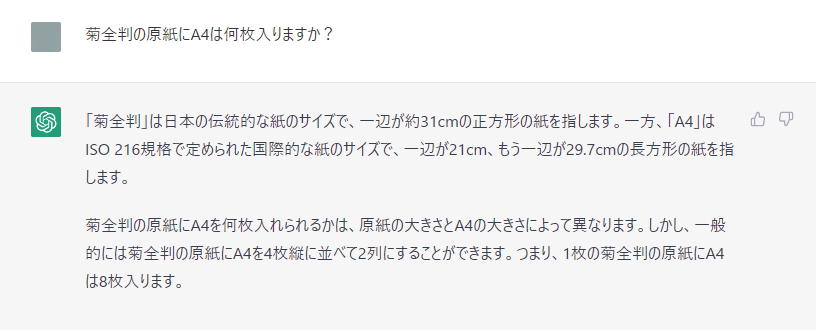

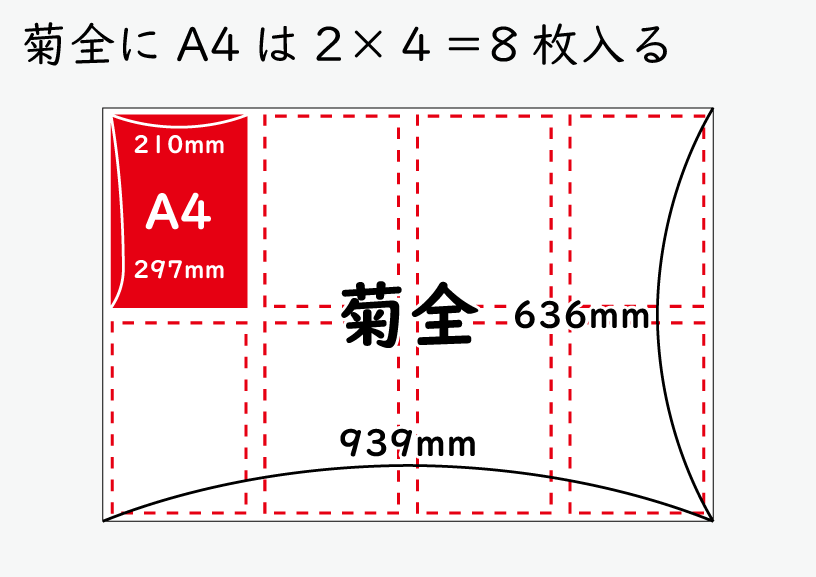

「菊全判の原紙にA4は何枚入りますか?」

これは製造設計の問題。「実際に印刷機にかける原紙に対して、印刷する絵柄をどのように配置すべきか」を検討するのが製造設計です。この問題で訊いていること自体はかなり初歩的な内容ですが、計算も発生する問題なので、ChatGPTがどう処理するのか気になるところ。

では訊いてみましょう……

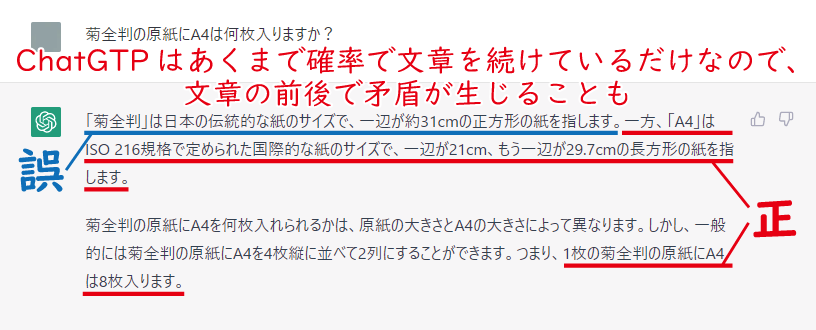

……これは不採用。なんだか様子がおかしいですね。

8枚入るという解答自体は正解です。ただ、菊全判のサイズを誤認しています。正しくは636mm × 939mmであるところを310mm×310mmとしているようです。もし仮に菊全がそのサイズなら、A4は1枚しか入らないはず。にもかかわらず8枚入るという解答になってしまっていますね。前提となる知識が誤っているのに、正しい結論が出ています。

実は、このねじれた解答にChatGPTの特徴があらわれています。さきほども書いたように、ChatGPTが生成する文章は出現確率に基づいて選び取られた単語の並びです。あくまで「この文章に続く単語はこれになる可能性が高いな」という推論で文章を生成しているので、文章全体の整合性が担保されているわけではありません。

問題に戻ると、一段落目の菊全判のサイズについてはまだ学習が足りていない様子。一方で二段落目の「A4を4枚縦に並べて2列にすることができる」「菊全判の原紙にA4は8枚入る」の2つの文章については学習データの中から正解をきちんと選び取れたようです。結果、前提の知識が誤っているのに結論は合っているという不思議な解答が出るわけですね。

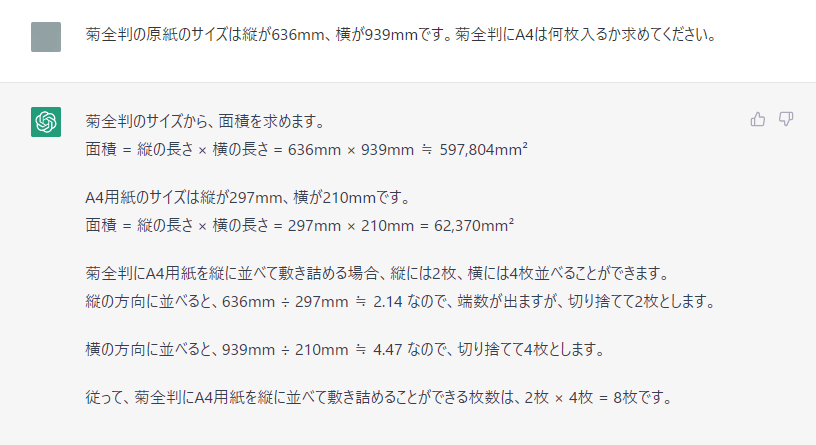

さすがに看過できないので、ちょっとテコ入れを行います。はじめに菊全判のサイズが636mm×939mmだという情報を与えてから同じ問題を解いてもらいましょう。

らしくなってきましたね。ただ、これでも模範解答とするのは難しそうです。

菊全判とA4の面積をそれぞれ求めていますが、解法には不要。ほかにも「636mm × 939mm ≒ 597,804mm2」とありますが、この場合は≒ではなく=を用いるのが自然でしょう。

また、上で書いたものを含め計算式が5つ出てきていますが、これらはいずれも実際に計算を行ったわけではありません。あくまで内部的には「636mm × 939mm とあるから、確率的に次に続くのは ≒ 597,804mm2 だろう……」という推論を行っているだけなので、解答が絶対に正しいという保証はありません。実際、ChatGPTに計算をさせると小学校レベルの問題でもミスを起こす例がいくつか見つかっています。AIが計算ミスをするというとなんだか違和感がありますね。

全面採用は難しそう

最後の最後でついに文章として矛盾した解答を出してしまったChatGPT。前編でもあったように、やはり「しくみの理解が若干怪しい」「結論は合っているが前提・過程に誤りがある」となると全幅の信頼を置くには不安があります。出題やフィードバックの仕方次第でもっと精度の高い回答が出てくるとは思うものの、何でもかんでも模範解答レベルのアウトプットを期待するのは難しそうです。

むしろ「答えは合っているけどところどころ怪しい」というのはかえって信用ならない傾向だとも言えます。「なんとなく」で理解してしまっているものほど、実際の仕事ではミスの原因になりがちですよね。もしChatGPTのような新人がいたら、指導の際には気を付けないといけません。

なんだかChatGPTに対して若干疑念が生まれる結果となりましたが、新人教育のヒントを手にした気がします。ありがとう、ChatGPT!